Представляем графические процессоры NVIDIA Tesla P4 для ускорения работы виртуальных рабочих станций и вывода ML на Compute Engine

Сегодня мы рады объявить о новом дополнении к семейству GPU для Google Cloud Platform (GCP), которое оптимизировано для приложений с интенсивным графическим интерфейсом и вывода машинного обучения: графический процессор NVIDIA Tesla P4.

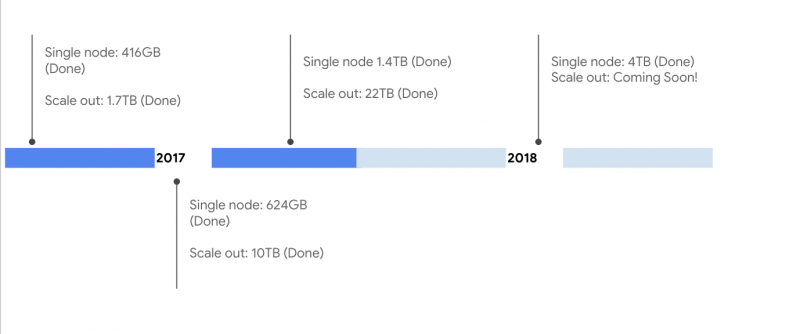

Мы прошли долгий путь с тех пор, как мы представили наш ускоритель вычислений первого поколения — графический процессор K80, добавляющий по графическим процессорам P100 и V100, которые оптимизированы для машинного обучения и рабочих нагрузок HPC. Новые P4-ускорители, теперь в бета-версии, обеспечивают хороший баланс цены / производительности для приложений удаленного отображения и вывода машинного обучения в режиме реального времени.

Графические приложения, которые работают в облаке, значительно выигрывают от графических процессоров на рабочих станциях. Теперь мы поддерживаем виртуальные рабочие станции с помощью NVIDIA GRID на P4 и P100, позволяя вам превратить любой экземпляр с одним или несколькими GPU в высокопроизводительную рабочую станцию, оптимизированную для использования с графическим ускорением. Теперь художники, архитекторы и инженеры могут создавать захватывающие 3D-сцены для своего следующего блокбастера или создавать компьютерную фотореалистичную композицию. P4s обеспечивают 8 ГБ памяти GDDR5 — достаточную мощность для чрезвычайно требовательных интерактивных и захватывающих 3D-приложений.

Один из ранних клиентов Schlumberger был впечатлен гибкостью, которую виртуальные рабочие станции Google Cloud предлагают клиентам нефти и газа.

Использование графических процессоров для облачных 3D-приложений является обязательным. Чтобы помочь создать максимально возможные виртуальные рабочие станции, мы также сотрудничаем с Teradici, который предлагает клиента, который работает на Compute Engine и доступен через GCP Marketplace.

Графические процессоры NVIDIA Tesla P4 также отлично подходят для случаев использования вывода ML, таких как визуальный поиск, интерактивные речевые и видео-рекомендации. Эти ускорители предлагают до 22 ТОПов производительности INT8 и могут сократить время ожидания на 40X по сравнению с традиционными процессорами. Наконец, P4s хорошо подходят для работы с транскодированием видео. Процессоры P4 с одним декодированием и двумя кодировками могут транскодировать до 35 видеопотоков HD в режиме реального времени.

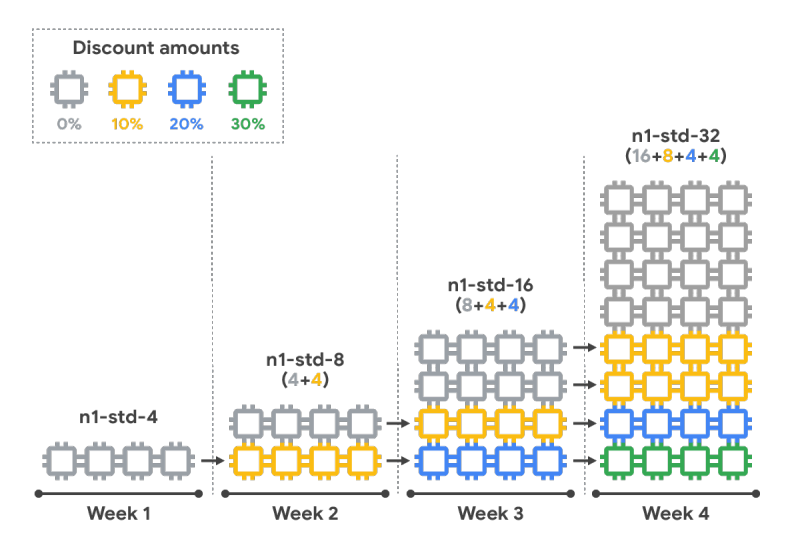

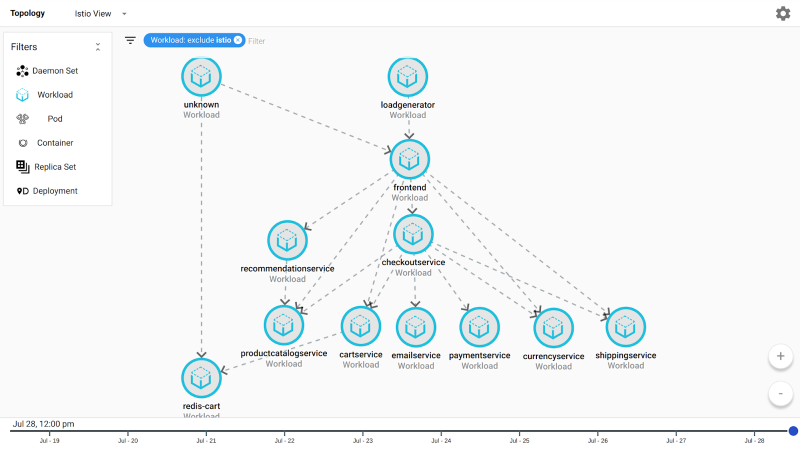

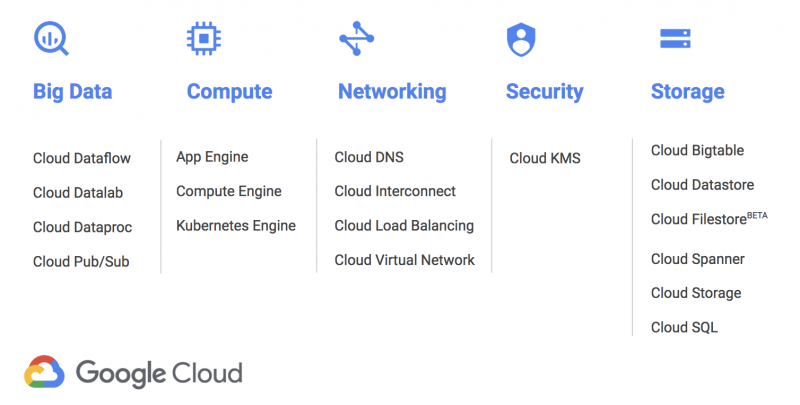

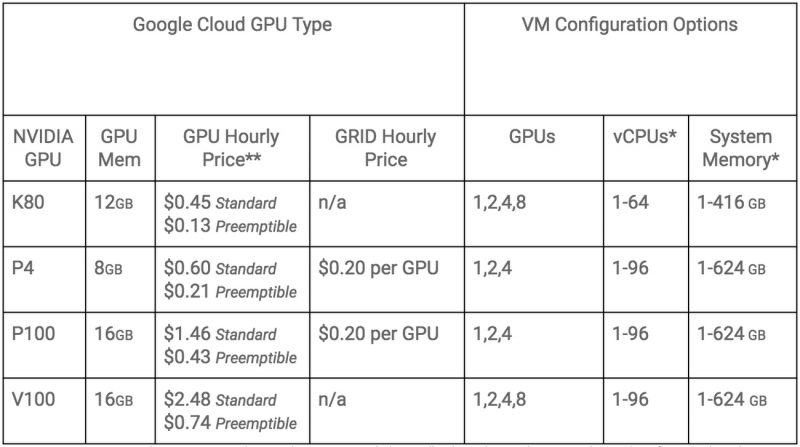

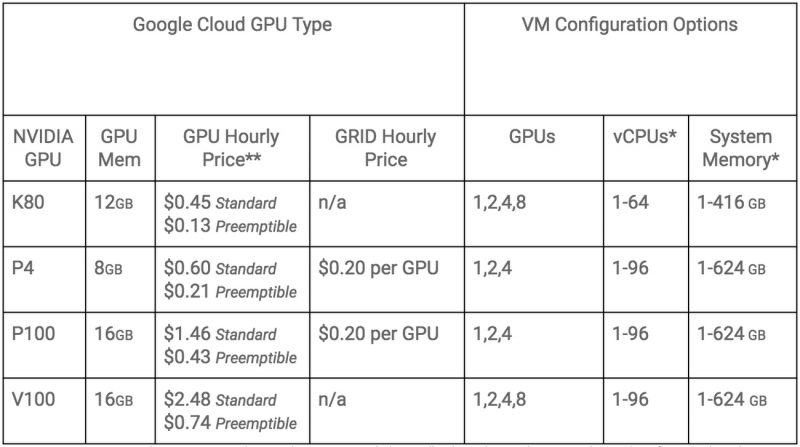

Как и в других наших предложениях для GPU, вы можете присоединить один или несколько P4 к любому типу машины и заплатить только за ресурсы, которые вам нужны. Мы поддерживаем все наши графические процессоры, в том числе P4, на Kubernetes Engine и движок для обучения машинам в облачной машине, визуализацию zync, и они могут воспользоваться преимуществами постоянных дисконтов и преимущественной ценой. P4s доступны сегодня в отдельных зонах в us-central1 (Айова), us-east4 (N. Virginia), Монреале (northamerica-северо-восток1) и europe-west4 (Нидерланды), с большим количеством регионов (включая LA). В приведенной ниже таблице представлен наш полный набор предложений GPU.

Наша цель — сотрудничать с вами и предоставлять аппаратные ресурсы, такие как ускорители, для управления всеми вашими рабочими нагрузками — будь то машинное обучение и обучение, моделирование, геномика, HPC, рендеринг и теперь, трехмерная визуализация. Чтобы узнать больше о P4 и виртуальных рабочих станциях на GCP, просмотрите страницу GPU или NVIDIA. Затем посетите консоль и приступайте к работе!

Мы прошли долгий путь с тех пор, как мы представили наш ускоритель вычислений первого поколения — графический процессор K80, добавляющий по графическим процессорам P100 и V100, которые оптимизированы для машинного обучения и рабочих нагрузок HPC. Новые P4-ускорители, теперь в бета-версии, обеспечивают хороший баланс цены / производительности для приложений удаленного отображения и вывода машинного обучения в режиме реального времени.

Графические приложения, которые работают в облаке, значительно выигрывают от графических процессоров на рабочих станциях. Теперь мы поддерживаем виртуальные рабочие станции с помощью NVIDIA GRID на P4 и P100, позволяя вам превратить любой экземпляр с одним или несколькими GPU в высокопроизводительную рабочую станцию, оптимизированную для использования с графическим ускорением. Теперь художники, архитекторы и инженеры могут создавать захватывающие 3D-сцены для своего следующего блокбастера или создавать компьютерную фотореалистичную композицию. P4s обеспечивают 8 ГБ памяти GDDR5 — достаточную мощность для чрезвычайно требовательных интерактивных и захватывающих 3D-приложений.

Один из ранних клиентов Schlumberger был впечатлен гибкостью, которую виртуальные рабочие станции Google Cloud предлагают клиентам нефти и газа.

Виртуальные рабочие станции Compute Engine, работающие на графических процессорах NVIDIA, позволяют нам решать самые сложные задачи визуализации облачных пользователей. Эксперты по теме «Нефть и газ» теперь могут использовать Petrotechnical Suite в когнитивной E & P среде DELFI от Schlumberger на различных устройствах с расширяющимся глобальным охватом. Благодаря сети Google Cloud и увеличению пропускной способности GPU для обеспечения низкой латентности, производительности виртуальных рабочих станций, наши клиенты могут использовать возможности облачных вычислений, чтобы принимать более обоснованные решения от разведки нефти и газа до производстваRaj Kannan, Advisor Solution Architect, Шлюмберже

Использование графических процессоров для облачных 3D-приложений является обязательным. Чтобы помочь создать максимально возможные виртуальные рабочие станции, мы также сотрудничаем с Teradici, который предлагает клиента, который работает на Compute Engine и доступен через GCP Marketplace.

Комбинация Teradici Cloud Access Software, облачной платформы Google и экземпляров NVIDIA P4 и P100 помогает предоставлять высокопроизводительные виртуальные рабочие станции. Теперь клиенты в таких отраслях, как медиа и развлечения, нефть и газ и производство, могут предоставить своим конечным пользователям возможность запускать вычислительные инструменты практически с любого устройства, практически в любой точке мираДэн Cordingley, генеральный директор, Teradici

Графические процессоры NVIDIA Tesla P4 также отлично подходят для случаев использования вывода ML, таких как визуальный поиск, интерактивные речевые и видео-рекомендации. Эти ускорители предлагают до 22 ТОПов производительности INT8 и могут сократить время ожидания на 40X по сравнению с традиционными процессорами. Наконец, P4s хорошо подходят для работы с транскодированием видео. Процессоры P4 с одним декодированием и двумя кодировками могут транскодировать до 35 видеопотоков HD в режиме реального времени.

Как и в других наших предложениях для GPU, вы можете присоединить один или несколько P4 к любому типу машины и заплатить только за ресурсы, которые вам нужны. Мы поддерживаем все наши графические процессоры, в том числе P4, на Kubernetes Engine и движок для обучения машинам в облачной машине, визуализацию zync, и они могут воспользоваться преимуществами постоянных дисконтов и преимущественной ценой. P4s доступны сегодня в отдельных зонах в us-central1 (Айова), us-east4 (N. Virginia), Монреале (northamerica-северо-восток1) и europe-west4 (Нидерланды), с большим количеством регионов (включая LA). В приведенной ниже таблице представлен наш полный набор предложений GPU.

Наша цель — сотрудничать с вами и предоставлять аппаратные ресурсы, такие как ускорители, для управления всеми вашими рабочими нагрузками — будь то машинное обучение и обучение, моделирование, геномика, HPC, рендеринг и теперь, трехмерная визуализация. Чтобы узнать больше о P4 и виртуальных рабочих станциях на GCP, просмотрите страницу GPU или NVIDIA. Затем посетите консоль и приступайте к работе!